През повечето време, когато трябва да блокирате достъпа SeekportBot или други crawl bots с уебсайт причините са прости. Мрежовият паяк прави твърде много достъпи за кратък период от време и изисква ресурсите на уеб сървъра или идва от търсачка, в която не искате уебсайтът ви да бъде индексиран.

Много е полезно за уебсайт, посещаван от crawБлъснах се в него. Тези уеб паяци са предназначени да изследват, обработват и индексират съдържанието на уеб страници в търсачките. Google и Bing използват такива crawБлъснах се в него. Има обаче и търсачки, които използват роботи за събиране на данни от уеб страници. Seekport е една от тези търсачки, която използва crawSeekportBot ler за индексиране на уеб страници. За съжаление, понякога го използва прекомерно и създава ненужен трафик.

съдържание

Какво е SeekportBot?

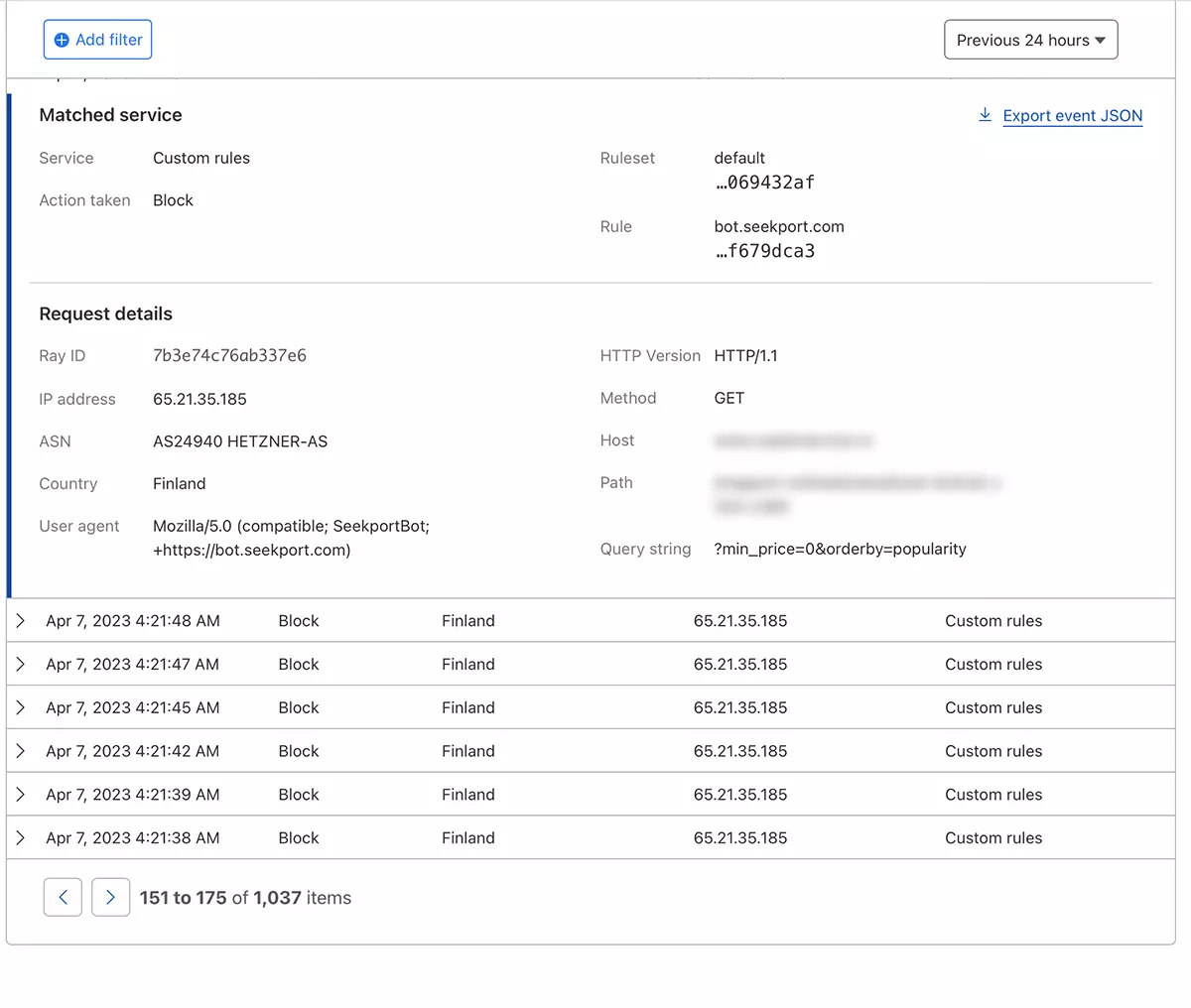

SeekportBot е web crawler разработен от компанията Seekport, който е базиран в Германия (но използва IP от няколко държави, включително Финландия). Този бот се използва за обхождане и индексиране на уебсайтове, така че да могат да се показват в резултатите от търсачките. Seekport. Неработеща търсачка, доколкото мога да преценя. Поне не върна никакви резултати за мен за нито една ключова фраза.

SeekportBot Употреба user agent:

"Mozilla/5.0 (compatible; SeekportBot; +https://bot.seekport.com)"Как да блокирате достъпа до SeekportBot или друг crawЩракнах върху уебсайт

Ако сте стигнали до извода, че този уеб паяк или друг, не е необходимо да сканирате целия си уебсайт и да правите ненужен трафик към уеб сървъра, имате няколко метода, чрез които можете да блокирате достъпа им.

Защитна стена на ниво уеб сървър

Те са приложения за защитна стена open-source които могат да бъдат инсталирани на операционни системи Linux и може да бъде конфигуриран да блокира трафик въз основа на няколко критерия. IP адрес, местоположение, портове, протоколи или потребителски агент.

APF (Advanced Policy Firewall) е такъв софтуер, чрез който можете да блокирате нежелани ботове, на ниво сървър.

Тъй като SeekportBot и други уеб паяци използват множество блокове от IP адреси, най-ефективното правило за блокиране се основава на "user agent". Така че, ако искате да блокирате достъпа SeekportBot с помощта на APF, всичко, което трябва да направите, е да се свържете с уеб сървъра чрез SSHи добавете правилото за филтър в конфигурационния файл.

1. Отворете конфигурационния файл с nano (или друго издателство).

sudo nano /etc/apf/conf.apf2. Потърсете реда, който започва с „IG_TCP_CPORTS” и добавете потребителския агент, който искате да блокирате, в края на този ред, последван от запетая. Например, ако искате да блокирате user agent "SeekportBot", редът трябва да изглежда така:

IG_TCP_CPORTS="80,443,22" && IG_TCP_CPORTS="$IG_TCP_CPORTS,SeekportBot"3. Запазете файла и рестартирайте услугата APF.

sudo systemctl restart apf.serviceДостъпът на "SeekportBot" ще бъде блокиран.

Филтър web crawls с помощта на Cloudflare – Блокирайте достъпа на SeekportBot

С помощта на Cloudflare ми се струва най-безопасният и удобен метод, чрез който можете да ограничите достъпа на някои ботове до уебсайт по различни начини. Методът, който използвах и в случая SeekportBot за филтриране на трафика към онлайн магазин.

Ако приемем, че вече сте добавили уебсайта към Cloudflare и DNS услугите са активирани (т.е. трафикът към уебсайта минава през Cloudflare), следвайте стъпките по-долу:

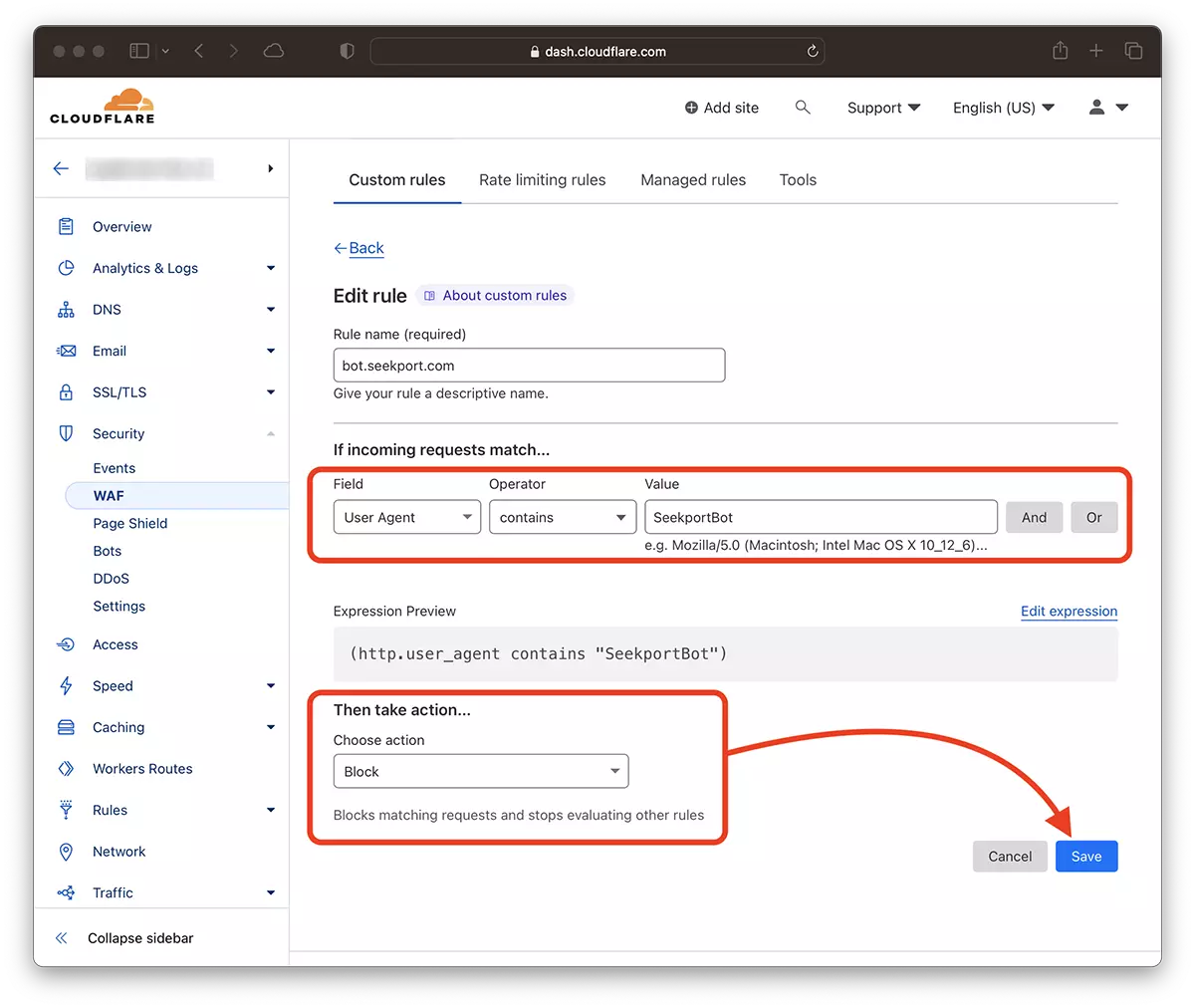

1. Отворете акаунта си в Clouflare и отидете на уебсайта, за който искате да ограничите достъпа.

2. Отидете на: Security → WAF и добавете ново правило. Create rule.

3. Изберете име за новото правило, Field: User Agent - Operator: Contains - Value: SeekportBot (или друго име на бот) – Choose action: Block - Deploy.

Само след няколко секунди новото правило WAF (Web Application Firewall) започва да действа.

На теория може да се зададе честотата, с която уеб паяк осъществява достъп до сайт robots.txt, но... това е само на теория.

User-agent: SeekportBot

Crawl-delay: 4Много web crawlerii (с изключение на Bing и Google) не спазват тези правила.

В заключение, ако идентифицирате уеб crawl който има прекомерен достъп до вашия сайт, най-добре е да блокирате напълно достъпа му. Разбира се, ако този бот не е от търсачка, в която желаете да присъствате.